Tarsi skaitmeninė kaukė

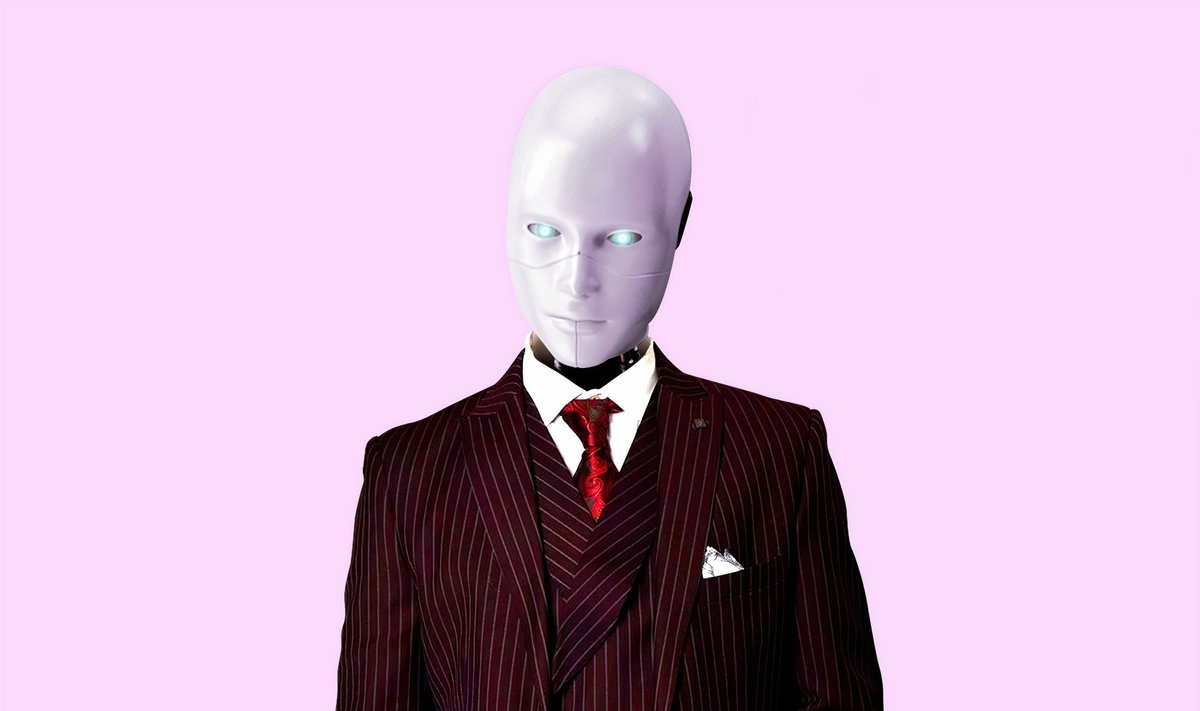

Portalas „Buzzfeed“ parodė, kas būtų, jei kalbėtų aktorius, o jo mimikas kompiuteris perkeltų ant Baracko Obamos veido. Per tuos dvejus metus sintetinių vaizdo klastočių (arba „deepfake“) technologijos gerokai patobulėjo.

Vaizdo klastotės paremtos dirbtiniu intelektu, kuris padeda sukurti įtikinamą vaizdo ar garso įrašą. Neurotinklai nuskaito vaizdo įrašą, kurį norima suklastoti. Tada susipažįsta su vaizdo įrašu, pagal kurį bus klastojama. Galima naudoti ir tūkstančius nuotraukų žmogaus, kurį norima suklastoti. Kompiuteris per keliolika minučių gali sukurti gana įtikinamą vaizdą, kuriame klastojamo žmogaus mimikos juda pagal naują kalbamą tekstą.

Viskas paremta mašininiu mokymusi, taigi, palikus kompiuterį sintetinti vaizdus bent 2 paroms, rezultatas žymiai pagerėja. Kitaip tariant, kuo daugiau laiko duodame kompiuteriui, tuo jis geriau išmoksta padirbti vaizdo įrašą. Tiesa, tam nereikia didžiulio superkompiuterio, o užtenka galingo žaidimams skirto kompiuterio su gera vaizdo plokšte.

Ironiška, bet ši technologija pirmiausiai įsivyravo pornografijoje, kur aktoriams uždedamos skaitmeninės įžymybių kaukės. Vėliau „deepfake“ technologija pradėta naudoti kine, kai reikia pakeisti aktorius arba kaskadininkus paversti tikromis pagrindinių herojų kopijomis. Akivaizdu, ir tuo pačiu baisu, kad kitas žingsnis – politika ir naujienos.

Kol kas bandymai sintezuoti Rusijos prezidento Vladimiro Putino ar JAV prezidento Donaldo Trumpo pasisakymus nebuvo tokie sėkmingi ir nepasiekė pagrindinių žiniasklaidos kanalų. Tačiau negalima atmesti galimybės, kad yra pavienių asmenų, kurie patikėjo suklastotais vaizdo įrašais ir vis dar gyvena kažkieno (gal ir ne iš blogų paskatų) sukurtoje realybėje.

Ieškokite kvadrato

„Ši technologija mane labai žavi iš techninės pusės, bet, turiu pripažinti, aš šiek tiek dvejoju dėl jos gerumo pasaulyje. Ji turi privalumų – puikių pritaikymų kino industrijoje. Tačiau ta rizika, kuri atsiranda su bendru nepasitikėjimu tuo, ką matome savo akimis, mane iš tiesų baugina“ – laidoje „Mokslo sriuba“ kalbėjo programuotojas ir dizaineris Jonas Lekevičius.

Jis viliasi, kad šiandien dar galima gana lengvai atpažinti sintetines klastotes. Tačiau technologijoms tobulėjant tai galės padaryti tik ekspertai. J. Lekevičius pataria kaip atskirti suklastotus vaizdo įrašus.

„Vaizdo įraše veidas nuo antakių iki smakro bus tarsi kvadratėlyje. Kartais to kvadratėlio ribas galima pamatyti. Tokiu atveju gali susidubliuoti antakiai arba matosi, kad išlenda skruostas. Tarsi veidas uždarytas į kvadratėlį ir nenori iš jo išlįsti“, – apie pirmąjį lakmuso popierėlį kalba ekspertas.

Profilio klastoti dar nemoka

Pasak jo, ryškiausiai išsiduoda profiliu pasisukęs suklastotas kalbėtojas. Taip yra todėl, kad dauguma nuotraukų su klastojamais žmonėmis būna iš priekio. Neurotinklams trūksta duomenų, kaip šis žmogus atrodytų kalbėdamas profiliu, todėl veido linija būna tarsi išskalauta kartu su fonu.

Fono klastojimas taip pat yra labai sunki užduotis kompiuteriui, nes sistema negali sužinoti, koks vaizdas yra už veido.

Tuo tarpu nuotraukas suklastoti žymiai lengviau, nes vienoje nuotraukoje yra mažiau informacijos nei vaizdo įraše. Pagalbos ranką čia tiesia kompanija „Adobe“. Jų sukurta „About Face“ programa leidžia 99 proc. tikslumu nustatyti, ar nuotrauka buvo retušuota ar ne.

Siūlome daugiau pasidomėti „deepfake“ technologija. Stebėti tokius vaizdus įdomu, tačiau svarbiausia – vystyti kritinį mąstymą ir nepamiršti, kad ne visi vaizdai kuriuos matome internete, yra tikri.

Užsakymo nr.: PT_85169405